Warum sind Grundlagen in der künstlichen Intelligenz so entscheidend? Grundlagen ermöglichen dir Hype, unwissenden Annahmen und selbst ernannten Experten kritisch zu hinterfragen.

Es kursiert aktuell die Meinung, dass das von OpenAI entwickelte Q* (ausgesprochen Q-Star) möglicherweise einen Durchbruch bei der Entwicklung von AGI (Artificial General Intelligence), darstellen könnte, wie eine Quelle Reuters berichtet. OpenAI definiert AGI als autonome Systeme, die den Menschen in den meisten wirtschaftlich wertvollen Aufgaben übertreffen.

Some at OpenAI believe Q* (pronounced Q-Star) could be a breakthrough in the startup’s search for what’s known as artificial general intelligence (AGI), one of the people told Reuters. OpenAI defines AGI as autonomous systems that surpass humans in most economically valuable tasks.

OpenAI researchers warned board of AI breakthrough ahead of CEO ouster, sources say, Reuters, 23 November 2023

Diese beiden Sätze von Reuters haben bei einigen Menschen Bedenken ausgelöst und zu Theorien und Vermutungen geführt, die auf Unwissenheit basieren. Lasst uns zunächst die Fakten und Grundlagen genauer betrachten.

- Q* ist keine Neuheit, die OpenAI kürzlich entdeckt hat. Die Forschung dazu geht bis ins Jahr 2017 zurück. Q* wurde unter anderem in OpenAI’s Gym (jetzt Gymnasium) verwendet, um Agenten zu testen.

- Q* ist ein Reinforcement Learning-Algorithmus. Reinforcement Learning (auf Deutsch: Bestärkendes Lernen) ist ein grundlegendes Konzept in der künstlichen Intelligenz. Bei diesem Ansatz lernt ein Algorithmus, indem er aufgrund seiner Handlungen Belohnungen oder Strafen erhält. Um Q* zu verstehen, ist es wichtig zu wissen, was Reinforcement Learning bedeutet.

- Q* ist ein besonderer Algorithmus, der nicht auf vorausgegangenen, trainierten Daten basiert, sondern aus den Ergebnissen seiner eigenen Aktionen lernt und diese für seine zukünftigen Entscheidungen berücksichtigt. Anders gesagt, er erstellt seine eigenen Trainingsdaten „on-the-fly“ und verwendet sie als Eingabe für weitere Verbesserungen.

Ein Beispiel, um Q-Star Learning besser zu verstehen.

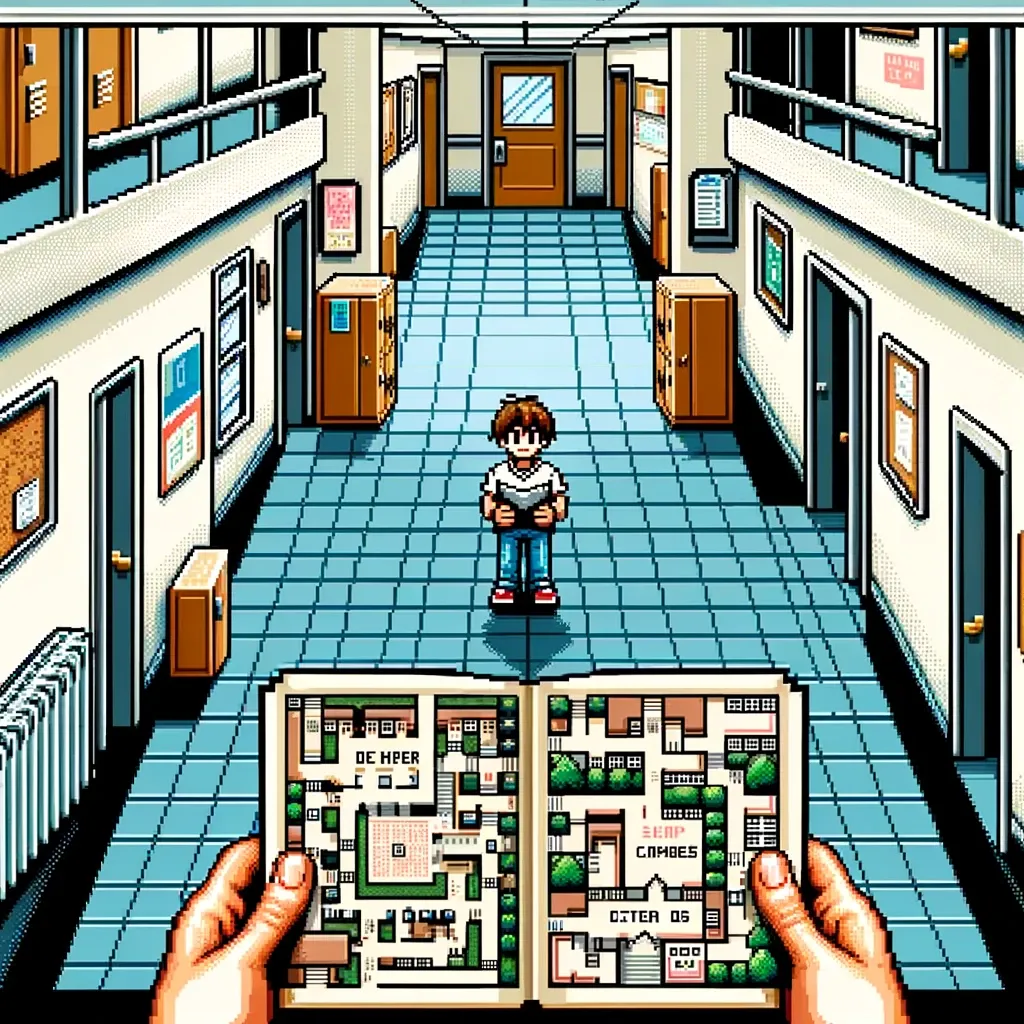

Stell dir vor, du bist ein Schüler, der durch eine Schule navigiert, in der jeder Klassenraum einen anderen Zustand darstellt und die Flure die Aktionen sind, die du nehmen kannst, um von einem Klassenraum (Zustand) in einen anderen zu gelangen.

- Klassenräume (Zustände): Jeder Klassenraum ist eine einzigartige Situation oder ein Zustand, in dem du dich befindest. In Q-Learning repräsentiert ein Zustand eine spezifische Situation oder Bedingung, in der sich der lernende Agent befindet.

- Flure (Aktionen): Um von einem Klassenraum in einen anderen zu gelangen, wählst du einen Flur. Ähnlich ist es im Q-Learning, wo eine Aktion das ist, was du entscheidest zu tun, um von einem Zustand in einen anderen zu wechseln. Diese Aktionen können dich zu verschiedenen Zuständen führen, genauso wie Flure zu verschiedenen Klassenräumen führen können.

- Karte mit Notizen (Q-Tabelle): Du trägst eine Karte (Q-Tabelle) bei dir, auf der du Notizen (Q-Werte) über jeden Flur (Aktion) machst, der aus jedem Klassenraum (Zustand) herausführt. Diese Notizen basieren auf zwei Dingen: deiner unmittelbaren Erfahrung (wie interessant oder langweilig der nächste Klassenraum ist – das repräsentiert die unmittelbare Belohnung im Q-Learning) und den besten Dingen, die du dir über die Klassenräume merkst, die du durch die Flure von dort erreichen kannst (was die zukünftigen Belohnungen repräsentiert).

- Erkundung (Verschiedene Flure ausprobieren): Anfangs erkundest du, indem du zufällig Flure auswählst. Dies ist wie die Erkundungsphase im Q-Learning, in der du verschiedene Aktionen ausprobierst, um zu sehen, welche Belohnungen sie bringen.

- Die besten Pfade lernen (Aktualisieren von Q-Werten): Mit der Zeit fängst du an herauszufinden, welche Flure zu den interessantesten Klassenräumen führen, und aktualisierst deine Karte mit besseren Notizen. Im Q-Learning ist dies wie das Aktualisieren der Q-Werte basierend auf den erhaltenen Belohnungen, was dir hilft zu lernen, welche Aktionen für jeden Zustand am besten sind.

- Optimierung der Route (Ausnutzen des erlernten Wissens): Schließlich wirst du sachkundig darüber, welche Flure insgesamt zu den besten Erfahrungen führen. Du beginnst, die lohnendsten Flure häufiger zu nutzen, während du immer noch gelegentlich neue ausprobierst, falls sich etwas geändert hat. Im Q-Learning ist dies die Phase, in der du beginnst, dein erlerntes Wissen auszunutzen, um die besten Entscheidungen zu treffen, während du immer noch ein wenig erkundest, um sicherzustellen, dass du keine potenziell besseren Pfade verpasst.

Ich hoffe die Analogie hat dir weitergeholfen Q-Star Learning zu verstehen. Ein Schüler, der durch die Schule (das Lernumfeld) navigiert, aus Erfahrungen lernt, um die besten Pfade (Aktionen) in verschiedenen Situationen (Zuständen) zu finden, um die gesamte Erfahrung (kumulative Belohnung) zu maximieren.

Wo verwendet man Q-Learning?

- Robotik

- Autonome Fahrzeuge

- Gesundheitswesen

- Finanzwesen

- Lieferketten- und Logistik

- Energiemanagement

- Bildungs- und Schulungssimulationen

Ob OpenAI nun eine neue Version von Q-Star entwickelt hat, die uns näher zu AGI führt, wissen wir nicht. Aus diesem Grund sollten wir mal den Ball flach halten und schauen was die nächsten Fakten uns bringen. Letzten Freitag wurde Sam Altman noch gekündigt und am Montag war er wieder CEO von OpenAI. 😉